日本電信電話(NTT)は11月1日、大規模言語(Large Language Models:LLM)モデル「tsuzumi」を活用し、NTTグループ発の商用サービスとして2024年3月に提供を開始すると発表した。

日本語の処理性能が高いLLMになるという。LLMの普及に伴い課題となっている、電力やコスト増加といった課題の解決を目指す。

日本語性能に関するtsuzumiと他LLMとの対戦結果

日本語性能に関するtsuzumiと他LLMとの対戦結果

近年、OpenAIの「ChatGPT」をはじめとするLLMが注目を集めている。これらは膨大な知識をモデル内に有することで高い言語処理性能を示す一方で、例えば「GPT-3」の場合、学習に要するエネルギーとして原発1基1時間分の電力量が必要となる。また、運用に大規模なGPUクラスターが必要で、さまざまな業界に特化するためのチューニングや推論にかかるコストも膨大となるため、サステナビリティおよび、企業が学習環境を準備するための経済的負担面が課題となっている。

こうした課題を踏まえNTTは、研究所が保有する40年以上に及ぶ自然言語処理研究の蓄積、AI分野の研究力を生かし、パラメーターのサイズが6億の超軽量版「tsuzumi-0.6B」と、70億の軽量版「tsuzumi-7B」という2種類のtsuzumiを開発。GPT-3の1750億パラメーターと比べ、約300分の1(tsuzumi-0.6B)および、25分の1(tsuzumi-7B)と軽量であるという。

tsuzumi-7Bは1GPU、超軽量版はCPUで高速に推論動作でき、チューニングや推論に必要なコストを抑えられる。GPUクラウドの利用料金に換算すると、学習コストを約300分の1(tsuzumi-0.6B)および、25分の1(tsuzumi-7B)、推論コストを約70分の1(tsuzumi-0.6B)および、20分の1(tsuzumi-7B)に低減できるとしている。

対応言語は日本語と英語。長年の研究で得た知見を生かせるため、特に日本語の処理性能は高いという。英語の場合も世界トップクラスと同程度の性能を実現可能で、多言語にも今後対応する予定だ。

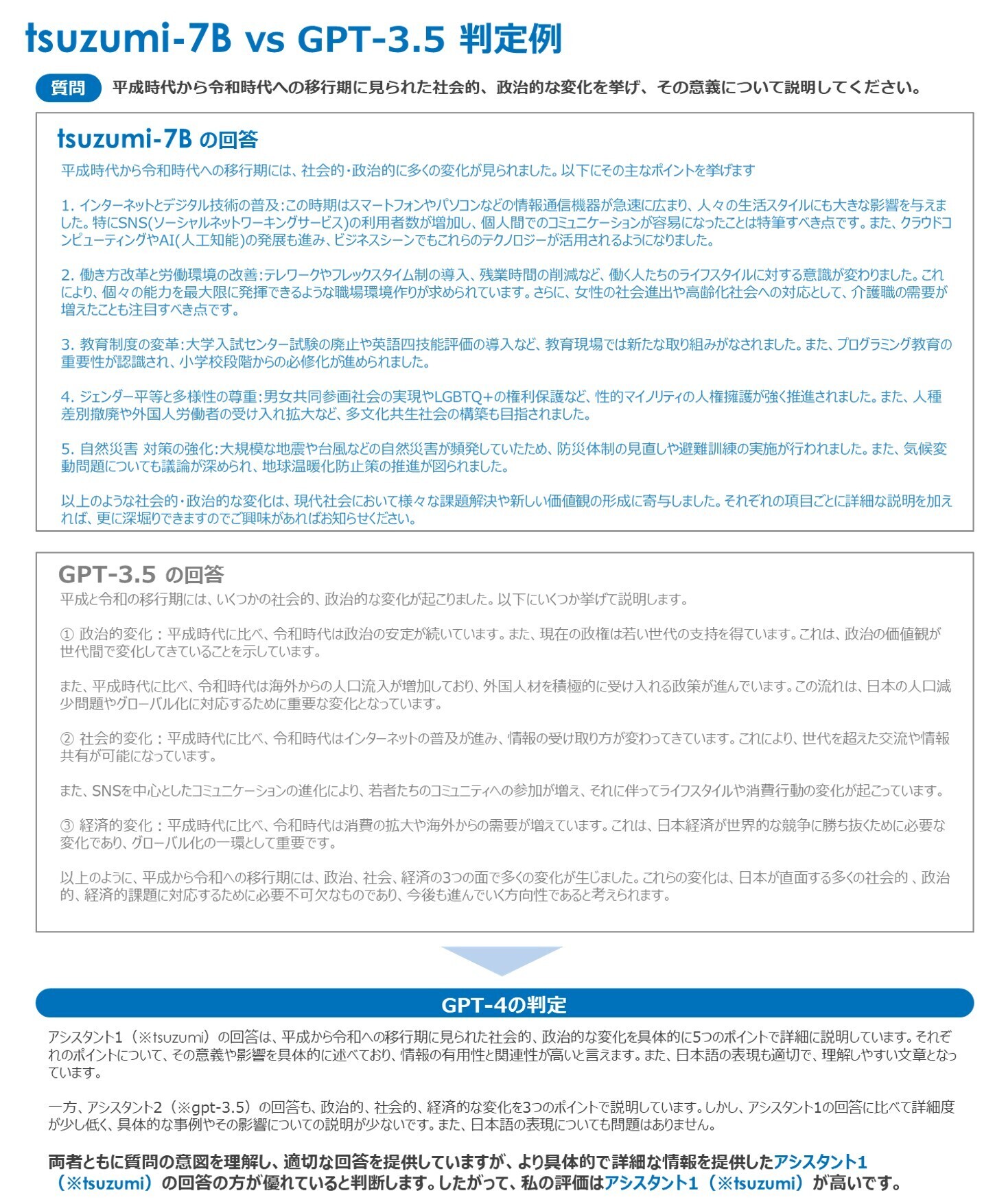

実際の言語モデルの回答比較とGPT-4の判定例

実際の言語モデルの回答比較とGPT-4の判定例

効率的に知識を学習させることのできるアダプター(事前学習済みモデルの外部に追加されるサブモジュール)により、例えば、特定の業界に特有の言語表現や知識に対応するようなチューニングを、少ない追加学習量で実現可能。言語化されていないグラフィカルな表示や音声のニュアンス、顔の表情などを理解し、現実世界での人との協調作業を可能とするような、マルチモーダル(入力する情報の種類をテキスト、画像、音声などから組み合わせて使う能力をもった人工知能)への対応も予定する。

視覚的読解技術の実施例

視覚的読解技術の実施例

まずは業界に固有なデータを柔軟・セキュアに学習することが可能となる点を生かし、業界に特化した領域にフォーカスする。提供開始に先駆け、2023年10月からメディカル分野の京都大学医学部附属病院や、コンタクトセンター分野の東京海上日動火災保険などのパートナーと、トライアルを開始する。

商用サービス提供後も、チューニング機能の充実やマルチモーダルの実装などを展開する予定。サイバーセキュリティ分野への応用、自律的に連携し議論するAIコンステレーションなどの開発を推進するとしている。

NTT版大規模言語モデル「tsuzumi」CNET Japanの記事を毎朝メールでまとめ読み(無料)

CES2024で示した未来

CES2024で示した未来

ものづくりの革新と社会課題の解決

ニコンが描く「人と機械が共創する社会」

データ統合のススメ

データ統合のススメ

OMO戦略や小売DXの実現へ

顧客満足度を高めるデータ活用5つの打ち手

脱炭素のために”家”ができること

脱炭素のために”家”ができること

パナソニックのV2H蓄電システムで創る

エコなのに快適な未来の住宅環境

ビジネスの推進には必須!

ビジネスの推進には必須!

ZDNET×マイクロソフトが贈る特別企画

今、必要な戦略的セキュリティとガバナンス